De AI Act: Een pakket aan stokken om mee te slaan, maar wie vangt de klappen?

Afgelopen woensdag was het zover: de AI act werd aangenomen. Hoewel het waarschijnlijk nog enkele jaren duurt voordat toezichthouders deze regels zullen handhaven, staat vast dat er nu een set regelgeving rondom AI is. In mijn boek “De AI Revolutie” behandel ik deze wetgeving al. Sommige aspecten, zoals duidelijke regels voor het gebruik van biometrische identificatie zoals gezichtsherkenning door autoriteiten, vind ik zeer positief. Maar er zijn ook zorgen: regelgeving kan de innovatiekracht van Europa op het gebied van kunstmatige intelligentie ernstig belemmeren, terwijl we al achterlopen. In dit artikel zal ik de aankomende regels bespreken en reflecteren op hun invloed.

De AI Act omvat in essentie een classificatie van verschillende AI-systemen. De wet verbiedt bepaalde vormen van kunstmatige intelligentie volledig, zoals gezichtsherkenning zonder wettelijke basis. Daarnaast identificeert de wet systemen met een hoog risico, zoals autonome voertuigen of algoritmes die medische diagnoses stellen, en plaatst deze in een aparte categorie. Voor “General Purpose AI” stelt de wet verplichtingen op het gebied van transparantie en documentatie.

Systemen die sociaal wenselijk gedrag beoordelen, zoals de algoritmes die in China gebruikt worden om inwoners te rangschikken op basis van hun gedrag, worden volledig verboden. Het is begrijpelijk dat er zorgen bestaan over dergelijke systemen. Toch is het opmerkelijk dat er in een samenleving waarin monetair belonen van wenselijk gedrag gangbaar is, zo’n radicale afwijzing bestaat tegen het concept van sociale kredietsystemen. Dit terwijl de gehele westerse samenleving eigenlijk op een vergelijkbaar concept gebouwd lijkt. De ironie dat het kapitalisme, als een van de eerste en grootste systemen van sociaal krediet, in het westen is ontstaan, laat ik voor nu buiten beschouwing.

Het invoeren van een verbod op biometrische identificatie, zoals gezichtsherkenning, beschouw ik als een significante vooruitgang. Ondanks dat er uitzonderingen lijken te zijn voor politie en andere overheidsdiensten, is dit een stap in de juiste richting. Het is essentieel dat we alle algoritmes die op individueel niveau functioneren kritisch onder de loep nemen, omdat fouten ernstige gevolgen kunnen hebben voor betrokken personen. Algoritmes zijn immers niet onfeilbaar. Hoe de handhaving van deze regels precies vormgegeven zal worden, blijft nog onduidelijk. Echter, voor bedrijven zoals Clearview AI, die databases met van sociale media verzamelde gezichten onderhouden, zal het lastig worden om niet beboet te worden.

Het geplande verbod op systemen die menselijk gedrag manipuleren roept veel vragen op over de definitie en handhaving ervan. Het is moeilijk te voorspellen hoe autoriteiten dit precies gaan interpreteren en toepassen. Zou dit kunnen leiden tot een algemeen verbod op reclame? Of is er zelfs een kans dat social media platforms onder dit verbod vallen? Het spectrum van systemen die menselijk gedrag kunnen beïnvloeden is breed, en het is onduidelijk waar de grenzen zullen worden getrokken. Vanuit een breder perspectief bezien, zou men zelfs kunnen argumenteren dat taal en emoties systemen zijn die zijn geëvolueerd om menselijk gedrag te manipuleren.

Voor AI-systemen die als risicovol worden beschouwd, zoals die in gevoelige domeinen zoals medische zorg, mobiliteit en het democratische proces, worden strikte regels opgesteld. Deze omvatten verplichte impactbeoordelingen van AI-toepassingen, de vereiste om documentatie te verstrekken, en het zorgvuldig monitoren en testen van algoritmes. Dit lijkt redelijk, aangezien er bij beslissingen die invloed hebben op mensenlevens altijd een duidelijke verantwoording moet zijn. De implementatie van deze regels introduceert echter ook uitdagingen, waaronder mogelijke bureaucratische hinder voor innovatieve bedrijven. De noodzaak van uitgebreide documentatie en conformiteitstoetsingen zal waarschijnlijk leiden tot de opkomst van een nieuwe sector gericht op AI-compliance, wat de nadruk verschuift van innovatie naar naleving van regelgeving.

Deze verschuiving naar strengere regelgeving voor AI kan gezien worden als een tweesnijdend zwaard. Enerzijds kan het zorgen voor een hogere mate van veiligheid en betrouwbaarheid in Europese AI-systemen. Anderzijds kan deze strikte regelgeving de ontwikkeling en het concurrentievermogen van de Europese AI-industrie in de weg staan. Startups en kleinere ondernemingen, vaak de drijvende kracht achter innovatie, kunnen disproportioneel geraakt worden door de kosten en complexiteit die compliance met zich meebrengt. Dit kan hun vermogen om te concurreren en innoveren beperken. Hoewel toezichthouders zich waarschijnlijk voornamelijk zullen richten op het controleren van grote overtreders, vergelijkbaar met de aanpak bij privacywetgeving, blijft de druk op kleinere bedrijven om aan dezelfde eisen te voldoen bestaan. Dit roept vragen op over hoe een balans kan worden gevonden tussen het waarborgen van veiligheid en het stimuleren van innovatie binnen de Europese AI-sector.

Voor zogenoemde “General Purpose AI” (GPAI), systemen die veelzijdig inzetbaar zijn zonder dat ze voor elke nieuwe taak opnieuw geprogrammeerd hoeven te worden, zoals ChatGPT of Claude-3, worden specifieke regels voorgesteld. Een belangrijk aspect van deze regelgeving is de eis tot transparantie over de gebruikte trainingsdata. OpenAI, het bedrijf achter ChatGPT, is momenteel niet transparant over de inhoud van de gebruikte datasets. Mira Murati, CTO van OpenAI, zei recent in een interview niet te weten welke beelden gebruikt voor het nieuwe video model CORA. Het verplicht stellen voor bedrijven om open te zijn over welke data is gebruikt voor het ontwikkelen van Large Language Models (LLMs), zou het mogelijk maken om te traceren welk materiaal is ingezet bij hun training. Dit zou bijdragen aan een grotere transparantie en verantwoordelijkheid in de ontwikkeling van AI-systemen, waardoor gebruikers en toezichthouders een beter inzicht krijgen in de werking en basis van deze technologieën.

De EU AI Act implementatie introduceert krachtige handhavingsmechanismen om te garanderen dat iedereen de gestelde eisen naleeft. Overtreders van de wet kunnen rekenen op forse boetes, die oplopen tot 7% van de wereldwijde jaaromzet of €35 miljoen als zij verboden AI-gebruik overtreden, en tot 3% of €15 miljoen voor de meeste andere overtredingen. Dit betekent dat een technologiegigant zoals Microsoft, met een jaaromzet van 56,5 miljard dollar, bijna 4 miljard dollar aan boetes kan verwachten als ze de regels niet volgen.

Ik vermoed dat, ondanks de dreiging van grote boetes, de grote techbedrijven blij zijn met de nieuwe regels, omdat deze hen vooral zullen helpen hun monopolieposities op verschillende deelgebieden te behouden door de sector kapot te reguleren en daarmee te bevriezen in de huidige staat.

Persoonlijk denk ik dat we slimmer hadden gehandeld door de wetten niet in één groot pakket te verpakken. Het vertalen van de AI act naar structurele handhavingsmethoden zal nog jaren in beslag nemen. In Nederland is er bijvoorbeeld geen capaciteit om klachten bij de Autoriteit Persoonsgegevens te verwerken, wat leidt tot een enorme achterstand. Waarom maken we niet gewoon duidelijke en eenvoudige, op zichzelf staande regels zoals een verbod op automatisch spelende video’s? Of een verplichting voor bedrijven die grote taalmodellen produceren om transparant te zijn over hun trainingsdata? Door het in één keer invoeren van een groot pakket aan regels zullen, afgezien van wat mooie persberichten en recordboetes, waarschijnlijk geen daadwerkelijke veranderingen plaatsvinden.

De AI act lijkt vooral een arsenaal aan stokken te bieden om mee te slaan, maar het is de vraag wie er in Europa overblijft om daadwerkelijk mee geslagen te worden. Het lijkt erop dat de wetgeving zodanig ontworpen is dat het de innovatie eerder afremt dan bevordert, waardoor bedrijven die zich bezighouden met de ontwikkeling van kunstmatige intelligentie mogelijk andere oorden zullen opzoeken waar de regelgeving minder strikt is. Dit zou niet alleen een leegloop van talent en innovatie kunnen betekenen, maar ook dat Europa achterblijft in de wereldwijde race rond AI-ontwikkeling. Zo biedt de AI act talloze mogelijkheden om in te grijpen, maar blijft het onduidelijk bij wie er ingegrepen zal worden.

Meer lezen? Mijn boek ‘De AI Revolutie’ vertelt je alles wat je wilt weten.

Dit artikel is onderdeel van een serie rondom Maarten Sukel’s boek “De AI-Revolutie: Hoe kunstmatige intelligentie de maatschappij gaat veranderen (en daar nu al mee bezig is)”. Het boek duikt dieper in de invloed van AI op onze toekomst en hoe we als samenleving de juiste koers kunnen bepalen in deze nieuwe, spannende tijd. Het boek ligt op de planken in verschillende boekhandels of is online te bestellen.

Lees meer

Intelligent en schaalbaar AI-toezicht

Voor het Tijdschrift voor Toezicht schreef ik een essay over hoe we effectief toezicht op AI kunnen organiseren zonder innovatie te smoren. De huidige toezichtmechanismen zijn ontoereikend. De invoering van de AVG heeft ons geleerd dat reactieve handhaving niet werkt....

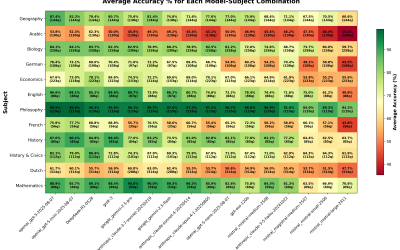

16 AI-modellen getest: 165x goedkoper, zelfde prestatie?

Om overzicht te krijgen welke taalmodellen goed werken voor Nederlandse toepassingen, testte ik 16 toonaangevende AI-modellen op duizenden echte Nederlandse eindexamenvragen. De resultaten zijn verrassend: sommige modellen kosten 165 keer meer dan anderen voor...

AI in de zorg: geen magie, wel een waardevolle hulp

Samen met Marcel Worring schreef ik voor NTVG een artikel over kunstmatige intelligentie in de zorg. We onderzoeken hoe AI en zorgprofessionals elkaar kunnen versterken, van diagnostiek tot patiëntmonitoring. Het stuk belicht zowel de veelbelovende mogelijkheden -...