Zitten we met de technologie van de toekomst vast in het verleden?

Wat heeft een eikenprocessierups te maken met hetero normatieve generatieve AI? Waarom lijken algoritmes steeds beter te worden, maar blijven ze toch dezelfde fouten maken? Deze week ga ik in op hoe de output van algoritmes kwalitatief beter lijkt, maar toch vaak dezelfde fouten worden gemaakt als een paar jaar geleden, en daarmee onze cultuur en omgangsvormen mogelijk vastzet in het verleden.

Toen ik eind 2022 afbeeldingen maakte van een koppel dat over het strand liep om in het boek De AI Revolutie te plaatsen, was ik destijds onder de indruk van de kwaliteit van de afbeeldingen. Wie de afbeeldingen van toen legt naast de kwaliteit van generatieve modellen begin 2024, ziet nu hoe snel de technologie zich heeft ontwikkeld.

Bron: Stable diffusion December 2022, prompt: “Een stel dat over het strand loopt”

Bron: DALL-E december 2023 prompt: maak een variant van de bovenstaande foto

Waarom is de kwaliteit van machine learning opeens zoveel beter?

De reden dat AI zo snel groeit, is dat de drie componenten die nodig zijn voor machine learning in overvloed aanwezig zijn.

Het eerste component is data. Er is nog nooit zoveel data in de wereld geweest, en we produceren en verzamelen ook meer dan ooit. Waar honderden jaren geleden de postduif het snelste communicatiemiddel was, is het nu mogelijk om in real-time ultrascherpe video zonder zichtbare vertraging naar de andere kant van de planeet te sturen. Daar komt nog bij dat we nog nooit zoveel sensoren bij ons hebben gedragen de hele dag. Smartphones hebben een camera, je kunt er teksten mee schrijven, je kunt er geluid mee opnemen, ze meten hoe je beweegt en je locatie mee bepalen. En ook slaan we al die informatie op het internet op, voornamelijk bij de grote techbedrijven.

Het tweede component is algoritmes. Door jaren aan onderzoek van universiteiten en techbedrijven is het juiste recept om data te verwerken gevonden. De manier waarop informatie wordt verwerkt, is door de academische wereld naar een ongekend niveau getild, met duizenden papers die elke week worden gepubliceerd die net weer wat effectiever werken. Voor de gekste taken wordt onderzoek gedaan om te zien hoe ze zo goed mogelijk kunnen worden uitgevoerd. Zelf ben ik een paper aan het publiceren waarin afbeeldingen en teksten van producten bij Picnic gebruikt kunnen worden om beter te voorspellen hoeveel mensen ervan gaan kopen. Oftewel: een foto van een aardappel gebruiken om te voorspellen hoeveel aardappelen mensen volgende week dinsdag gaan eten. Je kunt het zo gek nog niet bedenken of er zijn ergens wetenschappers bezig met het vinden van de ultieme formule.

Ten derde is er meer rekenkracht dan ooit, gigantische datacenters worden gebruikt om data-algoritmen af te stellen. Ook is de energie die hiervoor nodig is beschikbaar, want ja: deze rekenkracht consumeert erg veel energie. Wel is de rekenkracht momenteel een van de belemmerende factoren voor hoe goed bijvoorbeeld grootschalige taalmodellen als ChatGPT gemaakt kunnen worden. Vermoedelijk een van de redenen waarom Sam Altman, CEO van OpenAI, op zoek is naar een investering van 7 triljoen dollar om meer rekenkracht te verwezenlijken.

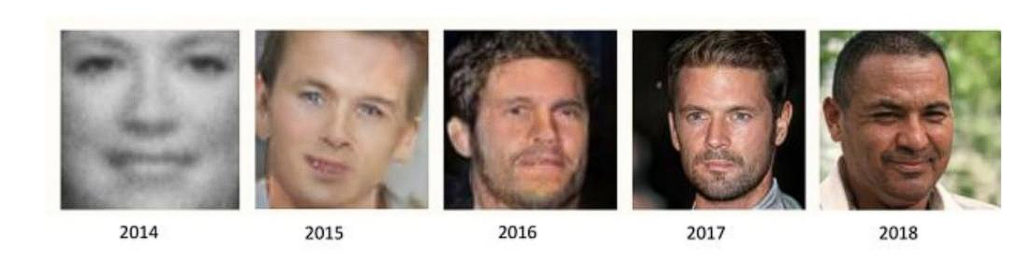

Dat de kwaliteit van AI beter is geworden, kan niemand ontkennen. Het deze week aangekondigde SORA van OpenAI laat revolutionaire kwaliteit van tekst naar video-generatie zien, iets wat een jaar geleden nog als onmogelijk werd gezien. De ontwikkeling is hard gegaan de afgelopen jaren, in de onderstaande afbeelding zie je hoe een menselijk gezicht kan worden gegenereerd door de jaren heen. De kwaliteit is een stuk beter.

Ontwikkeling van de kwaliteit van gegenereerde gezichten, bron: “Generative Deep Learning Teaching Machines to Paint, Write, Compose, and Play” van David Foster

Met technologie uit de toekomst vast in het verleden

Ik begon dit artikel met het voorbeeld van de generatieve afbeeldingen die ik in mijn boek “De AI Revolutie” wilde opnemen: de kwaliteit zou nu al verouderd zijn. Wat niet is veranderd, is dat de output van modellen nog steeds een weerspiegeling is van de input die ze krijgen.

Modellen zijn steeds beter geworden. Generatieve modellen zijn ontzettend snel beter geworden. Weliswaar is de kwaliteit in 2024 aanzienlijk verbeterd, en zijn de afbeeldingen prachtig om te zien. Desondanks is de heteronormatieve voorkeur van de modellen nog steeds zeer aanwezig. De prinses in de penarie die wordt gered door de prins op het witte paard. Leonardo DiCaprio en Kate Winslet in de Titanic. We zijn allemaal opgegroeid met een bepaalde rolverdeling tussen man en vrouw. Generatieve modellen leren ook op basis van beelden uit het verleden en zullen net als bij mensen stereotypen in stand houden. Heteronormatieve rolmodellen zijn ook op andere manieren aanwezig: wanneer je generatieve modellen vraagt om een afbeelding van een verpleger te genereren, zal dit bijna altijd gaan om een vrouw. Net zoals rolverdelingen in de samenleving zijn geïntegreerd, zijn deze nu ook een onderdeel geworden van de data die gebruikt is om beeldgeneratie modellen te maken.

Bron: Stable diffusion December 2022, prompt: “Een verpleegkundige”

Bron: DALL-E december 2023 prompt: maak een variant van de bovenstaande foto

Bij generatieve modellen is het vaak duidelijk dat er gebruik is gemaakt van heteronormatieve trainingsdata om de modellen te maken. Dat is ook niet vreemd: de trainingsdata komen voornamelijk uit een periode waar heterorelaties nog als enige breed geaccepteerd werden. Het roept vragen op over de wendbaarheid die nog bestaat in culturele normen in een wereld waar machine learning het verleden blijft echoën. Welke bewegingsruimte is er nog voor de ontwikkeling van omgangsnormen in een wereld waar generatieve AI bepaalt wat we zien?

Dit zal niet alleen invloed hebben op hoe we relaties met elkaar aangaan. Ook andere zaken zullen blijven weerklinken uit het verleden. Denk aan nationale identiteit: een Italiaan staat in de keuken en eet pasta, een Nederlander draagt klompen in een veld met tulpen, en Amerikanen eten fastfood, dragen vlaggen en wapens.

Het is fascinerend hoe de kwaliteit van generatieve modellen steeds beter is geworden, maar dat de echokamer van stereotypen een probleem is in de kern van de technologie: patronen uit het verleden herhalen. Er is een methode om dit tegen te gaan, zowel bij generatieve AI als bij andere algoritmes. Hiervoor is het wel essentieel te erkennen dat de technologie op deze manier werkt. Wanneer algoritmes die keuzes over mensen maken of invloed op mensen hebben niet goed worden gemonitord, dan is het mogelijk dat het initieel minder opvalt dat stereotypes en zelfs discriminatie niet opvallen. Vaak wordt de kop in het zand gestoken, want het algoritme is nou eenmaal op data getraind en maakt daarmee de best mogelijke voorspelling? Of toch niet? Data is nooit een correcte representatie van de werkelijkheid en wordt altijd verzameld met een bepaalde bias; het is immers nog niet mogelijk om de volledige werkelijkheid aan machine learning modellen te geven

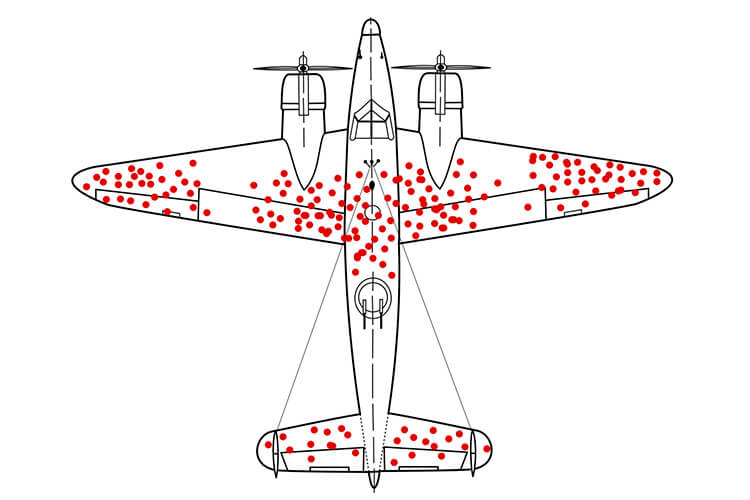

Een beroemd voorbeeld van selectiebias komt uit de Tweede Wereldoorlog. Op basis van analyses van schade aan vliegtuigen probeerde men in te schatten wat de kwetsbare onderdelen waren. Echter, deze data was niet erg goed om te gebruiken. De vliegtuigen die echt op kritieke plaatsen werden geraakt, storten namelijk neer en konden niet meer worden geanalyseerd. Dit concept heet survivor bias: je kan alleen data opslaan van objecten die terugkomen van missies.

Voorbeeld van hoe survivor ship bias zorgt voor een incorrecte dataset.

Er zijn veel verschillende vormen van bias. Denk aan data die is verzameld in een ziekenhuis in Nederland, waarschijnlijk zijn er meer patiënten met een Nederlandse afkomst. Dat wil niet zeggen dat mensen met een niet-Nederlandse afkomst niet in Nederland ziek kunnen worden. Wel zullen algoritmes die worden gemaakt op deze data het beter doen voor Nederlanders.

Er zijn manieren om bias te herkennen, maar zoals gezegd, is het meest essentiële bias te erkennen. Algoritmes moeten goed worden geëvalueerd en continu worden gemonitord. De wereld verandert continu, en algoritmes moeten dus ook af en toe worden bijgesteld. Zo waren algoritmes die verkeerspatronen voorspelden de eerste maanden van de coronalockdowns hopeloos in de war: de gedragingen van mensen die werden gebruikt om drukte in te schatten, kwamen totaal niet meer overeen met wat gebruikelijk was in de jaren ervoor.

Hetzelfde geldt voor een algoritme dat ik ooit maakte voor het routeren van meldingen bij gemeenten. Ze hadden nog nooit van de eikenprocessierups gehoord: logisch, aangezien het ook een invasieve soort is. De meldingen werden herkend als gaande over bomen: in de oude voorbeelden was het woord ‘boom’ altijd een melding over een boom. Door goed te monitoren en van gebruikers feedback te krijgen op incorrecte meldingen, is dat een kwestie van de categorie toevoegen en de algoritmes opnieuw afstellen.

Het voorbeeld van de eikenprocessierups is natuurlijk niet kwalijk. Maar je kunt je voorstellen dat hetzelfde kan gebeuren bij algoritmes van de belastingdienst of fraude detectie bij banken. Hierbij is het nog essentiëler dat zogeheten ‘data drift’ altijd in de gaten wordt gehouden. Wanneer er keuzes worden gemaakt die impactvol zijn voor mensen, is het essentieel dat algoritmes nauwkeurig worden gemonitord en dat er gekwalificeerde professionals hierbij betrokken zijn.

Hoewel algoritmes beter en beter worden, blijven ze vaak dezelfde fouten maken. Bij het ontwikkelen en het gebruik van algoritmes is het noodzakelijk je bewust te zijn van de oneerlijke effecten die kunnen optreden door fouten die algoritmen vaak maken: door ze te corrigeren, is het mogelijk een eerlijkere wereld te maken, door ze blind te vertrouwen ontstaat een oneerlijkere wereld.

Meer lezen? Mijn boek ‘De AI Revolutie’ vertelt je alles wat je wilt weten.

Dit artikel is onderdeel van een serie rondom Maarten Sukel’s boek “De AI-Revolutie: Hoe kunstmatige intelligentie de maatschappij gaat veranderen (en daar nu al mee bezig is)”. Het boek duikt dieper in de invloed van AI op onze toekomst en hoe we als samenleving de juiste koers kunnen bepalen in deze nieuwe, spannende tijd. Het boek ligt op de planken in verschillende boekhandels of is online te bestellen.

Lees meer

Emoticons op kinderfoto’s worden makkelijk weggehaald door AI. Dit kun je doen om misbruik tegen te gaan

Kan AI een sticker verwijderen op een foto van je kind? Nee dat kan niet, maar het is wél mogelijk om op basis van andere beelden onderdelen van foto's in te vullen. Dat kan altijd al, maar wordt de afgelopen jaren snel makkelijker en beter. Gisteren belde Eymeke...

TikTok wordt overspoeld met racistische en seksistische AI-video’s, met miljarden weergaven per maand

Ik sprak van de week met Miluska van Rompu van de Volkskrant over een nieuw onderzoek van AI Forensics: TikTok wordt overspoeld met AI slob met vaak sterke racistische of seksistische kenmerken.In mijn boek “De AI Revolutie” ging ik al in op een snel toenemende...

Intelligent en schaalbaar AI-toezicht

Voor het Tijdschrift voor Toezicht schreef ik een essay over hoe we effectief toezicht op AI kunnen organiseren zonder innovatie te smoren. De huidige toezichtmechanismen zijn ontoereikend. De invoering van de AVG heeft ons geleerd dat reactieve handhaving niet werkt....