Nieuws & Updates

Spotlight

Meer nieuws

Intelligent en schaalbaar AI-toezicht

Voor het Tijdschrift voor Toezicht schreef ik een essay over hoe we effectief toezicht op AI kunnen organiseren zonder innovatie te smoren. De huidige toezichtmechanismen zijn ontoereikend. De invoering van de AVG heeft ons geleerd dat reactieve handhaving niet werkt....

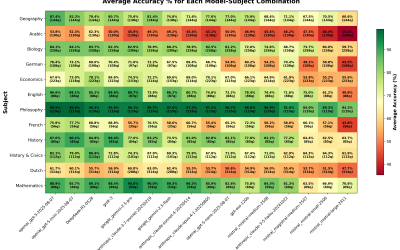

16 AI-modellen getest: 165x goedkoper, zelfde prestatie?

Om overzicht te krijgen welke taalmodellen goed werken voor Nederlandse toepassingen, testte ik 16 toonaangevende AI-modellen op duizenden echte Nederlandse eindexamenvragen. De resultaten zijn verrassend: sommige modellen kosten 165 keer meer dan anderen voor...

AI in de zorg: geen magie, wel een waardevolle hulp

Samen met Marcel Worring schreef ik voor NTVG een artikel over kunstmatige intelligentie in de zorg. We onderzoeken hoe AI en zorgprofessionals elkaar kunnen versterken, van diagnostiek tot patiëntmonitoring. Het stuk belicht zowel de veelbelovende mogelijkheden -...

AI-foto’s wurmen zich tussen Google-resultaten

In samenwerking met de Volkskrant deed ik onderzoek naar de invasie van AI-gegenereerde afbeeldingen in Google's zoekresultaten. Het blijkt dat kunstmatige intelligentie zich steeds vaker tussen echte beelden wurmt - bij onderwerpen als 'beauty' is maar 69% van de...

De AI-revolutie door de ogen van een pionier

Als Machine Learning Engineer en oprichter van The AI Factory ontwikkelt Maarten Sukel AI-systemen. Daarnaast is hij auteur van De AI Revolutie en promoveerde hij aan de Universiteit van Amsterdam op AI. Op C-day25 is hij keynote spreker. Maarten zijn standpunt?...

BeleidsRadar.nl maakt democratie transparanter met kunstmatige intelligentie

Wat gebeurt er echt in Den Haag en Brussel? Vanaf vandaag geeft BeleidsRadar.nl antwoord in seconden. Dr. Maarten Sukel lanceert namelijk een AI-assistent die politieke besluitvorming transparanter maakt. BeleidsRadar.nl zet zorgvuldig ontwikkelde AI-technologie in om...

dr Kelder en Co: AI: vloek of zegen?

Wordt de mens straks ingehaald door zijn eigen creatie? En hoe gaat kunstmatige intelligentie onze samenleving veranderen?dr. Maarten Sukel is AI-expert en net gepromoveerd op AI-oplossingen voor complexe maatschappelijke vraagstukken. Denk aan slimme camera’s die herkennen waar afval ligt op straat of apps die de verkoop van supermarkten voorspellen om zo de voedselverspilling te minimaliseren. Sukel praat met ons over de kansen en gevaren die aan deze technologie kleven. Want hoe zorgen we ervoor dat kunstmatige intelligentie niet ontwricht maar juist iets positiefs bijdraagt aan onze maatschappij?

Ik besteedde mijn geld om LLM’s te benchmarken op Nederlandse examens – zodat jij dat niet hoeft te doen

In dit blog deel ik mijn ervaringen met het benchmarken van verschillende grote taalmodellen (LLM’s) op basis van Nederlandse staatsexamens. Veel benchmarks richten zich op Engels, waardoor specifieke prestaties in het Nederlands vaak onderbelicht blijven. Ik verzamelde en verwerkte meer dan 12.000 PDF’s met examenvragen om inzicht te krijgen in hoe modellen zoals o1-mini, GPT-4o en Claude-3 presteren op begrijpend lezen en andere Nederlandstalige taken. Het resultaat? o1-mini blijkt beter én goedkoper te presteren dan duurdere modellen. Dit blog biedt waardevolle inzichten voor bedrijven die Nederlandstalige AI-toepassingen willen bouwen of opschalen.

Maarten Sukel over AI voor ouderen bij Meldpunt

Maarten Sukel, universitair onderzoeker en auteur van De AI Revolutie, vergelijkt de opkomst van kunstmatige intelligentie met de introductie van de stoomtrein tijdens de industriële revolutie. In de uitzending van MAX Meldpunt legt hij uit hoe AI het dagelijks leven van ouderen kan verrijken. Denk aan toepassingen zoals gezondheidszorg, waar AI vroegtijdig ziektes kan signaleren, of eenvoudige tools zoals een navigatie-app. Tegelijk erkent Sukel de zorgen en vragen rondom AI, en moedigt hij ouderen aan om op een laagdrempelige manier kennis te maken met deze technologie. “De stoomtrein is weer vertrokken, en AI biedt kansen voor iedereen.”

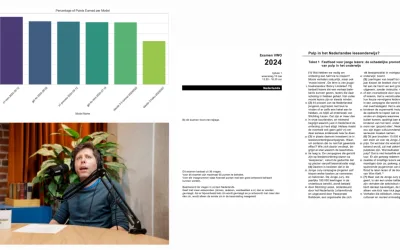

Gebruikt de Tweede Kamer ondanks een ‘verbod’ toch generatieve modellen om te schrijven (of reflecteren ze vaker)?

Gebruikt de Tweede Kamer ondanks een ‘verbod’ toch generatieve modellen om te schrijven (of reflecteren ze vaker)? Generatieve AI is als de uitvinding van het toetsenbord of van de pen: weigeren ermee te leren werken is een goede manier om boventallig te worden. Voor...

Muziek, kunst en (kunst)matige intelligentie

Muziek, kunst en (kunst)matige intelligentie Recentelijk heeft kunstmatige intelligentie (AI) voor opschudding gezorgd in de creatieve wereld, vooral binnen de muziekindustrie. Nieuwe platforms zoals Suno.ai en Udio stellen gebruikers in staat om binnen enkele...

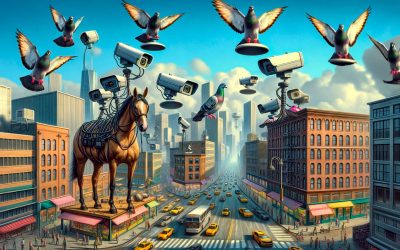

Waarom het geen goed idee is om camera’s aan duiven te hangen

Waarom het geen goed idee is om camera’s aan duiven te hangen. Slimme camera’s die hangen aan duiven en op het hoofd van paarden worden gezet om drugscriminaliteit tegen te gaan. Dit klinkt misschien als het scenario van een sciencefictionfilm, maar het werd (bijna)...

De digitale realiteit zijn we kwijt en komt ook niet meer terug

De digitale realiteit zijn we kwijt en komt ook niet meer terug. De opkomst van geavanceerde algoritmen, die in staat zijn om teksten, beelden en zelfs audio te genereren die nauwelijks van menselijke creaties te onderscheiden zijn, maakt het ontwikkelen van systemen...

Is social media het nieuwe tabak?

Is social media het nieuwe tabak? In 1930 werd er breed reclame gemaakt voor sigaretten: minder irritatie van de keel, lekker ontspannen en een hulpmiddel tegen hoesten. Nu, bijna 100 jaar later, is het duidelijk: roken veroorzaakt kanker en een breed scala aan...

Nederlandse Organisaties Flirten met Risicovolle Algoritmes

Nederlandse Organisaties Flirten met Risicovolle Algoritmes. Afgelopen week heb ik het nieuws rondom AI gevolgd en het viel me op dat er voortdurend keuzes werden gemaakt – sommige nadelig voor de samenleving en andere positief. Opvallend genoeg nam Google een goed...

Zitten we met de technologie van de toekomst vast in het verleden?

Zitten we met de technologie van de toekomst vast in het verleden? Wat heeft een eikenprocessierups te maken met hetero normatieve generatieve AI? Waarom lijken algoritmes steeds beter te worden, maar blijven ze toch dezelfde fouten maken? Deze week ga ik in op hoe de...

De AI Act: Een pakket aan stokken om mee te slaan, maar wie vangt de klappen?

De AI Act: Een pakket aan stokken om mee te slaan, maar wie vangt de klappen? Afgelopen woensdag was het zover: de AI act werd aangenomen. Hoewel het waarschijnlijk nog enkele jaren duurt voordat toezichthouders deze regels zullen handhaven, staat vast dat er nu een...

Moet AI-stemreplicatie verboden worden?

Moet AI-stemreplicatie verboden worden? Stemreplicatie is door recente technologische doorbraken eenvoudiger dan ooit. Tijdens de boekpresentatie van “De AI Revolutie” liet ik stemmen horen van Koning Willem Alexander, Burgemeester Femke Halsema en historicus Maarten...

Laten we anders praten over AI: Voorbij Hallucinaties en de Terminator

Laten we anders praten over AI: Voorbij Hallucinaties en de Terminator. Waarom heeft Hollywood ervoor gezorgd dat gesprekken over AI lastig zijn geworden? En waarom is het voor techbedrijven voordelig om een taalmodel dat incorrecte informatie geeft hallucinaties te...

Keuzes die we als samenleving maken over AI: Lessen van de Romeinen

Keuzes die we als samenleving maken over AI: Lessen van de Romeinen. Beslissingen van Romeinse werklieden, duizenden jaren geleden genomen, oefenen potentieel nog altijd invloed uit op het hedendaagse leven. Hoe zit dat precies? En op welke manier zullen de huidige...

Fragment uit ‘De AI Revolutie’

De AI-Revolutie: een introductie van een spannende serie. In deze wekelijkse serie van artikelen zal ik ingaan op diverse onderwerpen die ook in het boek ‘De AI-Revolutie’ aan bod komen. Deze week een fragment uit het boek om een idee te geven waar het over gaat. De...

Clearview AI krijgt megaboete, maar wanneer wordt de overheid gecontroleerd?

Clearview AI krijgt megaboete, maar wanneer wordt de overheid gecontroleerd? Clearview AI kreeg recent een boete van 30,5 miljoen euro voor het overtreden van de privacywetgeving door een database aan te leggen met gegevens van 30 miljard mensen (waarschijnlijk...

Brief aan de Tweede Kamer over de impact van generatieve AI op de samenleving

‘Generatieve AI raakt de samenleving tot in de haarvaten’. Dat staat in een gister verschenen brief van de hand van demissionair staatssecretaris Alexandra van Huffelen en demissionair ministers Micky Adriaansens en Robbert Dijkgraaf, waarin hun visie op deze technologie wordt beschreven. Schrijver Maarten Sukel praat erover bij Roos